Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 | 31 |

Tags

- 네이버커넥트재단

- NomadCoder

- RNN

- Sequential Model

- mutate( )

- 부스트캠프 aitech3기

- group_by( )

- Multi-Layer Perceptron

- 베이즈통계학

- r

- summarise( )

- regular expression

- col_names

- 생활코딩

- 네이버커넥트

- LinearNeuralNetwork

- Filter

- convolution 역전파

- 역전파알고리즘

- dplyr

- regex

- JavaScript

- 정규표현식

- 부스트캠프

- Convolution

- 모각공

- 자바스크립트

- Beyond Linear Neural Networks

- aitech

- 부스트캠프aitech3기

Archives

- Today

- Total

clear_uncertainty

네이버 부스트캠프 모각공 캠페인 10일차 - Sequential Models - RNN 본문

네이버 부스트캠프 - AI Tech 3rd/인공지능 본격 탐구: 딥러닝 기초

네이버 부스트캠프 모각공 캠페인 10일차 - Sequential Models - RNN

SOidentitiy 2021. 11. 19. 17:57728x90

모든 설명 및 자료의 출처는 네이버 부스트코스의 <[부스트캠프 AI Tech 3기] Pre-Course>입니다.

(https://www.boostcourse.org/onlyboostcampaitech3/joinLectures/329424)

<인공지능 본격 탐구: 딥러닝 기초>

Sequential Models - RNN

Sequential Model

Naive sequence model

Autoregressive model

Markov model (first-order autoregressive model)

Latent autoregressive model

Recurrent Neural Network

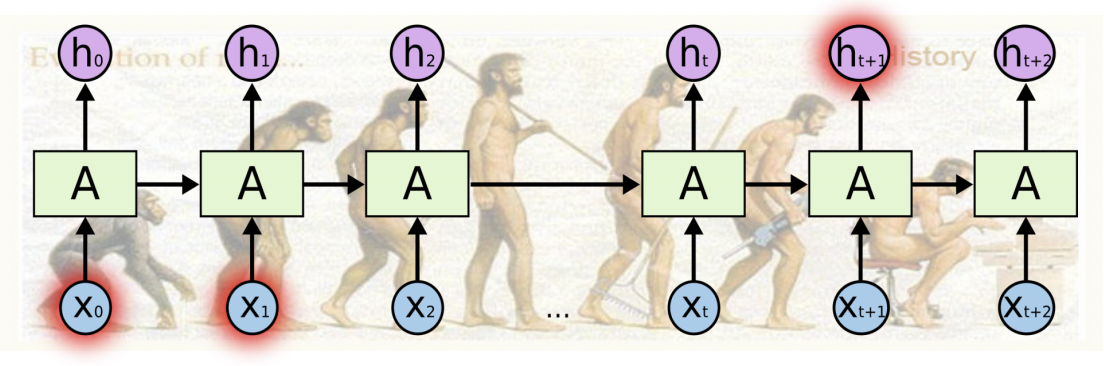

Short-term dependencies = RNN의 단점 , Short-term의 데이터만 주로 활용하고,

Long-term data를 활용하긴 힘들다.

Long-term dependencies

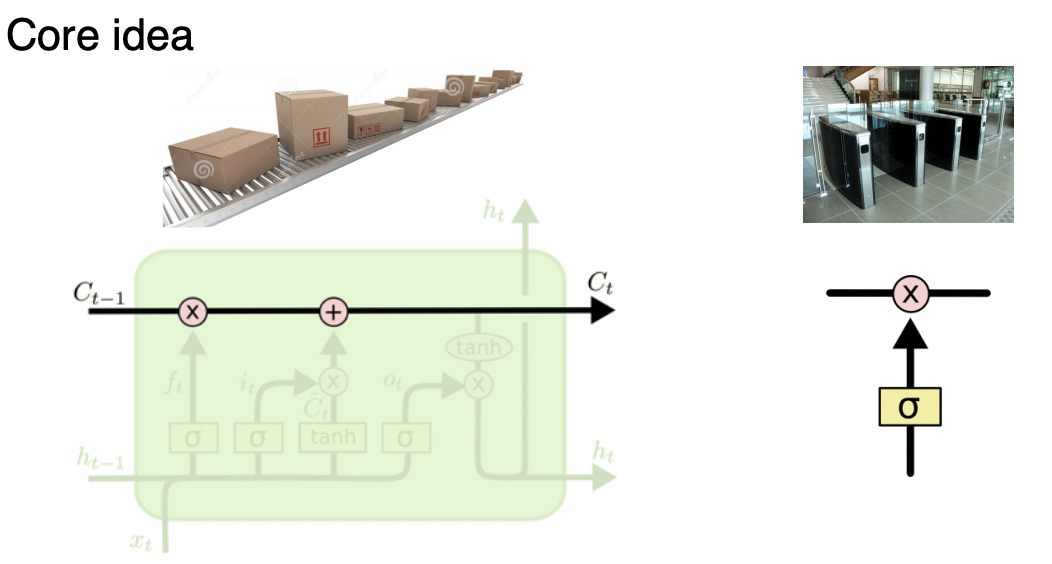

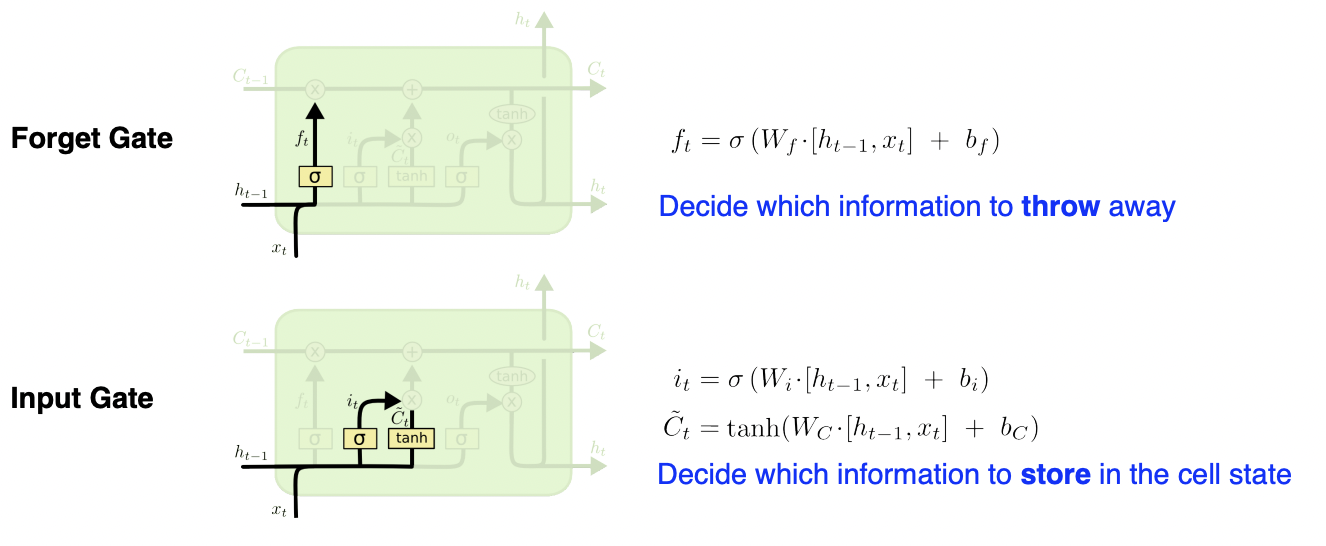

Long Short Term Memory

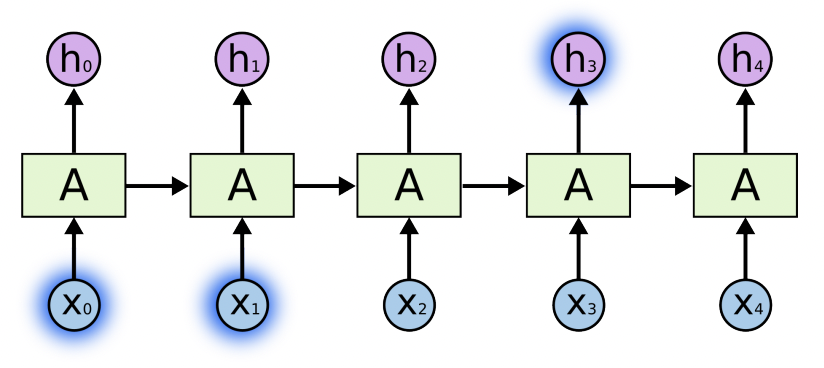

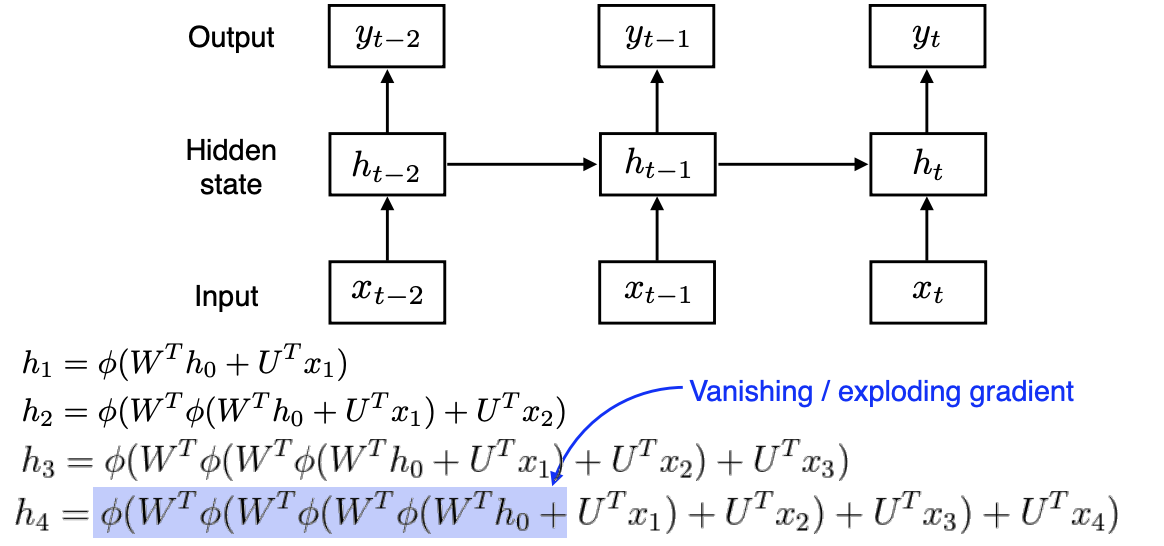

Recurrent Neural Network

가장 기본적인 RNN 구조

Long Short Term Memory = LSTM

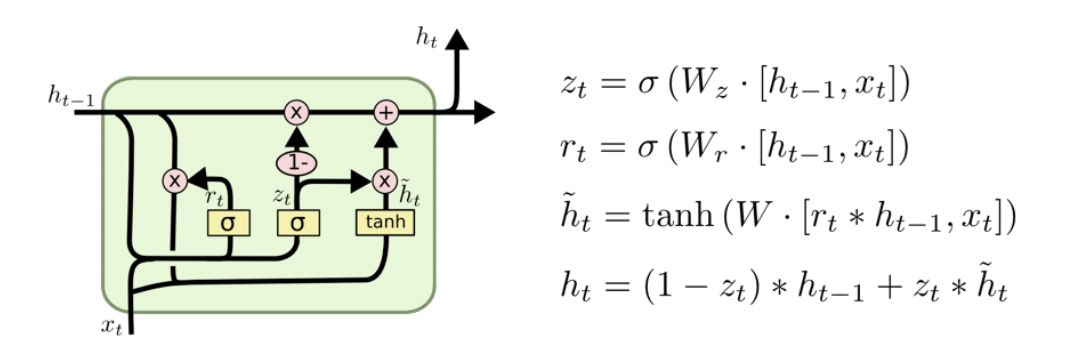

Gated Recurrent Unit = GRU

Simpler architecture with two gates (reset gate and update gate).

No cell state, just hidden state.

출처

[부스트캠프 AI Tech 3기] Pre-Course

728x90

'네이버 부스트캠프 - AI Tech 3rd > 인공지능 본격 탐구: 딥러닝 기초' 카테고리의 다른 글

| 네이버 부스트캠프 모각공 캠페인 10일차 - CNN-Convolution은 무엇인가? (0) | 2021.11.19 |

|---|---|

| 네이버 부스트캠프 모각공 캠페인 9일차 - Optimization (0) | 2021.11.18 |

| 네이버 부스트캠프 모각공 캠페인 9일차 - 뉴럴 네트워크 - MLP (Multi-Layer Perceptron) (0) | 2021.11.18 |